Big Data

Menurut (Eaton, Dirk, Tom, George, & Paul) Big Data merupakan istilah yang berlaku untuk informasi yang tidak dapat diproses atau dianalisis menggunakan alat tradisional.

Menurut (Dumbill, 2012) , Big Data adalah data yang melebihi proses kapasitas dari kovensi sistem database yang ada. Data terlalu besar dan terlalu cepat atau tidak sesuai dengan struktur arsitektur database yang ada. Untuk mendapatkan nilai dari data, maka harus memilih jalan altenatif untuk memprosesnya.

Berdasarkan pengertian para ahli di atas, dapat disimpulkan bahwa Big Data adalah data yang memiliki volume besar sehingga tidak dapat diproses menggunakan alat tradisional biasa dan harus menggunakan cara dan alat baru untuk mendapatkan nilai dari data ini.

Big Data mengacu pada dataset yang ukurannya diluar kemampuan dari database software tools untuk meng-capture, menyimpan,me-manage dan menganalisis. Definisi ini sengaja dibuat subjective agar mampu digabungkan oleh definisi Big Data yang masi belum ada baku. Ukuran big data sekitar beberapa lusin TeraByte sampai ke beberapa PetaByte tergantung jenis Industri Isi dari Big Data adalah Transaksi+interaksi dan observasi atau bisa di bilang segalanya yang berhubungan dengan jaringan internet, jaringan komunikasi, dan jaringan satelit.

Big data dapat di artikan kedalam 9 karakter (IBM) menurut responden sehingga disimpulkan oleh IBM, Big data adalah data yang memiliki scope informasi yang sangat besar, model informasi yang real-time, memiliki volume yang besar, dan berasalkan social media data jadi dapat disimpulkan bahwa Big data adalah dataset yang memiliki volume besar dan salah satu isinya berdasarkan social media data, dan informasi dari Big data selalu yang terbaru (latestdata) sehingga model informasi nya real-time, dan scope informasi nya tidak terfocus pada industri-indrustri kecil saja atau industri-indrustri besar saja melainkan semuanya baik industry kecil maupun besar.

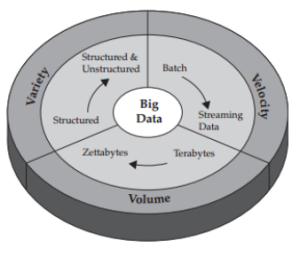

Dimensi-dimensi Big Data

Ada 3 dimensi awal dalam Big Data yaitu 3V: Volume, Variety dan Velocity. Berikut penjelasan dari masing-masing dimeni tersebut.

- Volume

perusahaan tertimbun dengan data yang terus tumbuh dari semua jenis sektor, dengan mudah mengumpulkan terabyte bahkan petabyte-informasi.

- Mengubah 12 terabyte Tweet dibuat setiap hari ke dalam peningkatan sentimen analisis produk.

- Mengkonvert 350 milliar pembacaan tahunan untuk lebih baik dalam memprediksi kemampuan beli pasar.

Mungkin karakteristik ini yang paling mudah dimengerti karena besarnya data. Volume juga mengacu pada jumlah massa data, bahwa organisasi berusaha untuk memanfaatkan data untuk meningkatkan pengambilan keputusan yang banyak perusahaan di banyak negara. Volume data juga terus meningkat dan belum pernah terjadi sampai sethinggi ini sehingga tidak dapat diprediksi jumlah pasti dan juga ukuran dari data sekitar lebih kecil dari petabyte sampai zetabyte. Dataset big data sekitar 1 terabyte sampai 1 petabyte perperusahaan jadi jika big data digabungkan dalam sebuah organisasi / group perusahaan ukurannya mungkin bisa sampai zetabyte dan jika hari ini jumlah data sampai 1000 zetabyte, besok pasti akan lebih tinggi dari 1000 zetabyte.

- Variety

Volume data yang banyak tersebut bertambah dengan kecepatan yang begitu cepat sehingga sulit bagi kita untuk mengelola hal tersebut. Kadang-kadang 2 menit sudah menjadi terlambat. Untuk proses dalam waktu sensitif seperti penangkapan penipuan, data yang besar harus digunakan sebagai aliran ke dalam perusahaan Anda untuk memaksimalkan nilainya.

- Meneliti 5 juta transaksi yang dibuat setiap hari untuk mengidentifikasi potensi penipuan

- Menganalisis 500 juta detail catatan panggilan setiap hari secara real-time untuk memprediksi gejolak pelanggan lebih cepat.

Berbagai jenis data dan sumber data. Variasi adalah tentang mengelolah kompleksitas beberapa jenis data, termasuk structured data, unstructured data dan semi-structured data. Organisasi perlu mengintegrasikan dan menganalisis data dari array yang kompleks dari kedua sumber informasi Traditional dan non traditional informasi, dari dalam dan luar perusahaan. Dengan begitu banyaknya sensor, perangkat pintar (smart device) dan teknologi kolaborasi sosial, data yang dihasilkan dalam bentuk yang tak terhitung jumlahnya, termasuk text, web data, tweet, sensor data, audio, video, click stream, log file dan banyak lagi.

- Velocity :

Big Data adalah setiap jenis data – data baik yang terstruktur maupun tidak terstruktur seperti teks, data sensor, audio, video, klik stream, file log dan banyak lagi. Wawasan baru ditemukan ketika menganalisis kedua jenis data ini bersama-sama.

- Memantau 100 video masukan langsung dari kamera pengintai untuk menargetkan tempat tujuan.

- Mengeksploitasi 80% perkembangan data dalam gambar, video, dan dokumen untuk meningkatkan kepuasan pelanggan.

Data dalam gerak. Kecepatan di mana data dibuat, diolah dan dianalisis terus menerus. Berkontribusi untuk kecepatan yang lebih tinggi adalah sifat penciptaan data secara real-time, serta kebutuhan untuk memasukkan streaming data ke dalam proses bisnis dan dalam pengambilan keputusan. Dampak Velocity latency, jeda waktu antara saat data dibuat atau data yang ditangkap, dan ketika itu juga dapat diakses. Hari ini, data terus-menerus dihasilkan pada kecepatan yang mustahil untuk sistem tradisional untuk menangkap, menyimpan dan menganalisis. Jenis tertentu dari data harus dianalisis secara real time untuk menjadi nilai bagi bisnis.

Infrastruktur dalam Big Data

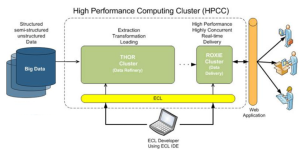

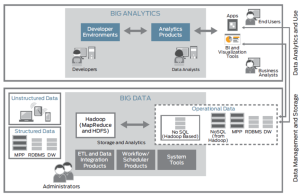

- High Performance Computing Cluster (HPCC) atau dapat disebut sebagai Data Analytics Supercomputer (DAS)

- Hadoop Platform (Map Reduced-Based Platform)

Dari kedua pendekatan teknologi tersebut terdapat perbedaan yang cukup signifikan (dari segi fungsi) dan juga terdapat kemiripan dalam proses yang berjalan didalamnya. Kemiripan dari dua teknologi tersebut adalah sama-sama memanfaatkan lebih dari satu komputer dalam melakukan proses penarikan informasi ataupun pemrosesan berbagai informasi atau bahkan dapat terlihat keduanya menggunakan konsep kluster pada arsitektur teknologi yang digunakan. Pada dasarnya keduanya pun dapat diintegrasikan dengan baik guna saling mendukung satu sama lain.

High Performance Compputing Clusters ini sendiri pada dasarnya membangun suatu super komputer yang terdiri dari lebih dari satu komputer dengan spesifikasi tertentu (biasanya sama) untuk saling membantu menopang, atau membagi tugas satu sama lain sehingga bersama-sama dapat melakukan processing terhadap suatu data, terutama dalam hal pencarian data. Proses besar yang biasanya berjalan sendiri adalah seperti, Ekstrak, Transform, dan Load, lalu setelah itu dilakukan analisis untuk mendapatkan informasi yang lebih sesuai dengan kebuthan bisnis organisasi tersebut.

Gambar High Performance Computing Cluster

Sedangkan Hadoop Platform sendiri merupakan suatu project teknologi yang dikembangkan oleh apache dalam mengelola data besar sehingga jauh lebih efektif dan efisien. Dalam hadoop sendiri terdiri dari berbagai komponen, bahkan hingga hadoop sendiri memiliki distributed file system sendiri yang disebut dengan (HDFS). Kelebihan dari dari HDFS ini sendiri adalah :

- Fault tolerance, dan di-deploy untuk low cost hardware

- Write Onece, Read many, merupakan koherensi sederhana, dan terlebih lagi framework yang dibangun dalam hadoop ketika kita akan menggunakan hadoop, menggunakan teknologi java.

- Memindahkan komputasi/proses lebih cepat dari memindahkan data.

- Mirip Google File System, tetapi HDFS membagi file menjadi block dalam cluster node yang terdistribusi.

- Core component : master vs slave, name node vs data node, job tracker vs task tracker.

Gambar arsitektur integrasi antara HPCC dan Hadoop platform

- Analisa data (OLAP)

OLAP (Online Analytical Proccessing) merupakan suatu proses yang digunakan untuk melakukan permintaan terhadap data dalam bentuk yang kompleks dan menganalisa data yang bervolume besar. OLAP merupakan teknologi yang memproses data di dalam database dalam struktur multidimensi, menyediakan jawaban yang cepat untuk query dan analisis yang kompleks. Data multidimensi adalah data yang dapat dimodelkan sebagai atribut dimensi dan atribut ukuran. Contoh atribut dimensi adalah nama barang dan warna barang, sedangkan contoh atribut ukuran adalah jumlah barang.

- OLTP

OLTP (Online Transactional Processing) merupakan sekumpulan fungsi yang bekerja secara bersama-sama dalam mengelola, mengumpulkan, menyimpan, memproses serta mendistribusikan informasi. OLTP (On-line Transaction Processing) memiliki karakteristik dengan jumlah data yang besar namun transaksi yang dilakukan cukup sederhana seperti insert,update, dan delete. Hal utama yang menjadi perhatian dari sistem yang dilakukan OLTP adalah melakukan query secara cepat, data mudah untuk diperbaiki dan dapat diakses melalui komputer yang terhubung dalam jaringan. OLTP berorientasi pada proses yang memproses suatu transaksi secara langsung melalui komputer yang terhubung dalam jaringan. Seperti misalanya kasir pada sebuah super market yang menggunakan mesin dalam proses transaksinya. OLTP mempunyai karakteristik beberapa user dapat creating, updating, retrieving untuk setiap record data.

- Data Mining

Secara sederhana data mining adalah suatu proses untuk menemukan interesting knowledge dari sejumlah data yang di simpan dalam basis data atau media penyimpanan data lainnya. Dengan melakukan data mining terhadap sekumpulan data, akan didapatkan suatu interesting pattern yang dapat disimpan sebagai knowledge baru.Pattern yang didapat akan digunakan untuk melakukan evaluasi terhadap data data tersebut untuk selanjutnya akan didapatkan informasi.

- ETL (Extraction, Transformation, Loading)

Tiga fungsi utama yang perlu dilakukan untuk membuat data siap digunakan pada datawarehouse adalah extraction, transformation dan loading. Ketiga fungsi ini terdapat pada staging area. Pada data staging ini, disediakan tempat dan area dengan beberapa fungsi seperti data cleansing, change, convert, dan menyiapkan data untuk disimpan serta digunakan oleh datawarehouse.

- Extraction

Data Extraction adalah proses pengambilan data yang diperlukan dari sumber datawarehouse dan selanjutnya dimasukkan pada staging area untuk diproses pada tahap berikutnya [2]. Pada fungsi ini, kita akan banyak berhubungan dengan berbagai tipe sumberdata. Format data, mesin yang berbeda, software dan arsitektur yang tidak sama. Sehingga sebelum proses ini kita lakukan, sebaiknya perlu kita definisikan requirement terhadap sumber data yang akan kita butuhkan untuk lebih memudahkan pada extraction data ini.

- Transformation

Pada kenyataannya, pada proses transaksional data disimpan dalam berbagai format sehingga jarang kita temui data yang konsisten antara aplikasi-aplikasi yang ada. Transformasi data ditujukan untuk mengatasi masalah ini. Dengan proses transformasi data ini, kita melakukan standarisasi terhadap data pada satu format yang konsisten. Beberapa contoh ketidakkonsistenan data tersenut dapat diakibatkan oleh tipe data yang berbeda, data length dan lain sebagainya

Keterangan :

- Format, Pada transaksional data dapat disimpan dalam berbagai format. Elemen data tersebut dapat tersimpan dalam format text, integer dan sebagainya. Untuk itu standarisasi perlu dilakukan dengan melihat kegunaan pokok dari elemen data pada proses transaksinal dan datawarehouse.

- Description, Pada tabel terlihat representasi ketiga nama pelanggan adalah sama. Namun dengan penulisan yang beda terlihat adanya perbedaan format pada data. Oleh karena itu perlu diambil salah satu dari deskripsi tersebut untuk konsistensi data.

- Unit, Adanya perbedaan satuan ukuran dapat menimbulkan permasalahan yang komplek. Jika user tidak mengetahui adanya perbedaan ini dan menganggap sama, maka akan terjadi kesalahan ketika kita melakukan penghitungan matematis.

- Encoding, huruf atau nomor dapat dijadikan label sebagi identifikasi suatu objek. Seperti pada tabel diatas, kesalahan dapat terjadi karenanya.

- Loading

Data loading adalah memindahkan data ke datawarehouse. Ada dua loading data yang di lakukan pada datawarehouse. Pertama adalah inisial load, proses ini dilakukan pada saat telah selesai mendesign dan membangun data warhouse. Data yang masukkan tentunya akan sangat besar dan memakan waktu yang relatif lebih lama. Kedua Incremental load, dilakukan ketika data warehouse telah dioperasikan. Sehingga akan lebih mudah melakukan data extraction, transformation dan loading terhadap data tersebut.

Data Warehouse

Data Warehouse adalah database yang didesain khusus untuk mengerjakan proses query, membuat laporan dan analisa. Data yang di simpan adalah data business history dari sebuah organisasi /perusahaan, dimana data tersebut tidak tersimpan secara rinci/detil. Sehingga data dapat bertahan lebih lama berbeda dengan data OLTP (Online Transactional Processing) yang tersimpan sampai prosesnya berlangsung secara lengkap.

Sumber data pada datawarehouse berasal dari berbagai macam format, software, platform dan jaringan yang beda. Data tersebut adalah hasil dari proses transaksi perusahan / organisasi sehari.hari. Karena berasal dari sumber yang berbeda beda tadi, maka data pada data warehouse harus tersimpan dalam sebuah format yang baku.

Data Warehouse juga merupakan salah satu sistem pendukung keputusan, yaitu dengan menyimpan data dari berbagai sumber, mengorganisasikannya dan dianalisa oleh para pengambil kebijakan. Akan tetapi datawarehouse tidak dapat memberikan keputusan secara langsung. Namun ia dapat memberikan informasi yang dapat membuat user menjadi lebih paham dalam membuat kebijakan strategis.

Adapun karakteristik umum yang dimiliki datawarehouse adalah :

- Data terintegrasi dari berbagai sumber yang berasal dari proses transaksional (OLTP)

- Data dibuat konsisten

- Merupakan aggregate data/kesimpulan data, bukan data yang terperinci

- Data bertahan lebih lama

- Data tersimpan dalam format yang tepat sehinngga proses query dan analisa dapat dilakukan dengan cepat

- Data bersifat read only

Data Mart

Apa Itu Data Mart?

© Unsplash.com

Pasar data berorientasi subjek yang berisi repositori data ringkasan.

Dikumpulkannya data-data ini adalah untuk analisis yang bermanfaat bagi bisnis, misalnya dalam bidang penjualan, keuangan, maupun marketing.

Jadi, arsip pusat akan menyimpan data bisnis secara keseluruhan, sementara data mart hanya meliputi subset data spesifik untuk kelompok pengguna tertentu.

Kumpulan data spesifik ini sangat berguna untuk mengisolasi set atau kumpulan data yang lebih kecil sehingga aksesnya lebih mudah bagi para end-user.

Jadi, tentunya pencarian dan pengambilan data akan menjadi lebih cepat.

Selain itu, Sisense menyatakan bahwa data mart juga mampu menghindarkan departemen-departemen dalam suatu perusahaan mengganggu data satu sama lain.

Jenis-Jenis Data Mart

© Unsplash.com

Ada dua cara sebuah bisnis bisa membangun data mart, yaitu:

- Membuat data mart dari data warehouse yang sudah ada.

- Membuat data mart independen dari data sumber dan menyusun data warehouse berdasarkan data tersebut.

Nah, ada beberapa jenis data mart yang bisa kamu susun.

Berikut penjelasannya:

1. Dependen

Data mart dependen mengambil sumber data organisasi dari data warehouse tunggal.

Jenis yang satu ini sifatnya tersentralisasi.

Menurut IBM, data mart dependen mengekstraksi subset dari primary data kapan pun dibutuhkan untuk analisis.

Ada dua pendekatan untuk menyusun data warehouse dependen.

Pertama, pengguna bisa mengakses data warehouse dan data mart-nya secara bebas, tergantung kebutuhannya.

Alternatif kedua yaitu pengguna hanya diberi akses pada data mart saja.

Cara yang kedua sering dianggap kurang bagus karena menghasilkan banyak data junkyard.

2. Independen

Jenis pasar data idependen dibuat tanpa menggunakan data warehouse sebagai pusat data.

Dibanding jenis dependen, data mart independen lebih sesuai untuk kelompok-kelompok kecil dalam sebuah organisasi.

Indicative menyatakan bahwa data mart independen biasanya berfokus pada satu fungsi bisnis saja.

Data untuk jenis data mart ini dimasukkan secara terpisah dan diperoleh dari sumber data internal maupun eksternal.

Sayangnya, data mart jenis independen cukup sulit untuk didesain dan dikembangkan.

Jenis ini berguna untuk mencapai tujuan dalam jangka pendek, meski cukup kompleks untuk diatur.

3. Hybrid

Data mart hybrid adalah jenis yang menggabungkan sumber-sumber selain dari data warehouse.

Jenis data mart ini sangat berguna jika ingin menambahkan kelompok baru ke dalam organisasi.

Merancang Data Mart

© Freepik.com

Data mart adalah salah satu cara atau sarana bisnis untuk membuat keputusan yang tepat.

Misalnya, tim marketing bisa menggunakan data mart sebagi proses menganalisis perilaku konsumen.

Data mart biasanya dibuat dan diatur oleh departemen bisnis yang akan menggunakannya

Nah, ada beberapa langkah yang perlu dilakukan untuk mendesain data mart, yakni:

1. Pencatatan kebutuhan yang penting

Dalam tahap ini, kamu perlu menuliskan dan mencatat semua kebutuhan bisnis serta teknis untuk data mart yang dibuat.

2. Identifikasi sumber data

Dari mana data yang akan kamu gunakan untuk membangun data mart?

Hal ini perlu dipertimbangkan agar informasi yang digunakan untuk data mart adalah yang benar-benar tepat.

3. Tentukan data subset

Tetapkan subset data untuk data mart, contohnya adalah informasi yang akan digunakan spesifik pada bidang tertentu atau cenderung umum.

4. Desain logical layout

Logical layout dalam data mart dapat dilakukan dengan memilih schema yang sesuai dengan data warehouse-nya.

Setelah keempat tahap tersebut dilakukan, kamu bisa menggunakan tool-tool business intelligence seperti Qlik atau SiSense agar pemahaman data semakin mudah.

Data Lake

Istilah data lake secara umum telah dicetuskan oleh CTO Pentaho James Dixon. Dia mendeskripsikan data mart (subset dari data warehouse) seperti sebotol air, “bersih, terkemas, serta terstruktur untuk konsumsi yang mudah” sementara data lake lebih menyerupai air dalam keadaan alaminya. Data mengalir dari sungai (sistem sumber) hingga ke danau. Pengguna memiliki akses ke danau untuk memeriksa, mengambil sampel atau bahkan menyelam ke dalamnya.

Walaupun cukup menjawab, tetapi definisi di atas tetap dianggap tidak terlalu akurat. Maka dari itu, ada beberapa sifat spesifik lain tentang data lake:

- Semua data dimuat dari sistem sumber. Tidak ada data yang ditolak.

- Data disimpan dalam bentuk yang tidak diubah atau hampir tidak berubah.

- Data ditransformasikan dan skemanya diaplikasikan untuk memenuhi kebutuhan analisis

Berikutnya, ada setidaknya lima perbedaan kunci antara data lake dan pendekatan data warehouse.

- Data Lake Mempertahankan Semua Data

Selama pengembangan data warehouse, cukup banyak waktu yang dihabiskan untuk menganalisa sumber-sumber data, memahami proses bisnis, dan data profiling. Hasilnya merupakan model data sangat terstruktur yang didesain untuk pelaporan. Bagian besar dari proses tersebut termasuk membuat keputusan tentang data apa yang dimasukkan dan yang tidak dimasukkan ke dalam warehouse. Umumnya, jika data tidak digunakan untuk menjawab pertanyaan-pertanyaan yang spesifik atau tidak dalam laporan yang didefinisikan, mungkin saja data itu tidak dimasukkan ke dalam warehouse. Hal ini biasanya dilakukan untuk menyederhanakan model data dan juga menghemat ruang pada disk penyimpanan mahal yang juga digunakan sebagai peningkat kinerja data warehouse.

Sebaliknya, data lake mempertahankan semua data. Tidak hanya data yang digunakan hari ini tetapi data yang mungkin sewaktu-waktu digunakan atau bahkan data yang kemungkinan tidak akan pernah digunakan sama sekali karena mungkin data itu akan digunakan pada satu keadaan tertentu. Data juga disimpan sepanjang waktu sehingga jika ada analisis yang harus dilakukan pada satu waktu, hal itu dapat dilakukan.

Pendekatan ini memungkinkan karena piranti keras untuk data lake biasanya sangat berbeda dari apa yang digunakan untuk data warehouse. Komoditas, server tanpa rak dikombinasikan dengan media penyimpanan murah membuat penskalaan data lake ke terabytes dan petabytes relatif ekonomis.

- Data Lake Men-support Segala Jenis Data

Data warehouse secara umum terdiri dari data yang diekstrak dari sistem transaksional dan terdiri dari matriks kuantitatif serta sifat-sifat yang mendeskripsikan mereka. Sumber data non-tradisional seperti log web server, data sensor, aktivitas jaringan sosial, teks dan gambar biasanya diabaikan. Penggunaan untuk tipe-tipe data seperti ini terus ditemukan tetapi cukup sulit untuk mengonsumsi dan menyimpan data-data ini, dan juga membutuhkan biaya yang mahal.

Pendekatan data lake mencakup tipe-tipe data non-tradisional seperti ini. Dalam data lake, perusahaan dapat menyimpan semua data dari manapun sumbernya dan bagaimanapun strukturnya. Perusahaan menyimpannya dalam bentuk data mentah dan hanya diubah saat data tersebut siap untuk digunakan. Pendekatan ini diketahui sebagai “Schema on Read” yang padanannya adalah “Schema on Write” yang digunakan pada data warehouse.

- Data Lake Mendukung Semua Pengguna

Di kebanyakkan perusahaan, 80 persen atau lebih pengguna merupakan “operasional”. Mereka ingin mendapatkan laporan mereka, melihat matriks kinerja mereka atau membagi data set yang sama di spreadsheet setiap harinya. Data warehouse biasanya cocok untuk para pengguna ini karena memiliki sifat mudah digunakan dan dipahami, terstruktur dengan baik, serta dibangun dengan tujuan khusus untuk menjawab pertanyaan mereka.

Sisa 10 persen atau lebih perusahaan lainnya, melakukan lebih banyak analisis pada data. Mereka menggunakan data warehouse sebagai sumber namun seringkali kembali pada source system untuk medapatkan data yang tidak dimasukkan dalam warehouse dan terkadang membawa data dari luar perusahaan. Alat favorit mereka adalah spreadsheet dan mereka membuat laporan-laporan baru yang didistribusikan ke seluruh perusahaan. Data warehouse merupakan sumber mereka untuk data tetapi mereka sering melewati batasannya.

Pada akhirnya, sisa beberapa persen terakhir dari pengguna melakukan analisis mendalam. Mereka mungkin menciptakan data yang benar-benar baru dan memiliki seluruh pertanyaan-pertanyaan baru untuk dijawab. Para pengguna ini termasuk Data Scientist dan mereka menggunakan alat analitik tingkat lanjut yang memiliki kapabilitas seperti analisis statistik dan model prediktif.

Pendekatan data lake mendukung semua pengguna ini dengan sama baiknya. Data scientist dapat menggunakan data lake dan bekerja dengan data set yang sangat besar dan beragam yang dibutuhkan sementara pengguna lainnya juga bisa menggunakan pandangan yang lebih terstruktur dari data yang tersedia untuk mereka manfaatkan.

- Data Lake Beradaptasi dengan Mudah pada Perubahan

Salah satu keluhan tentang data warehouse yang sering beredar adalah berapa lama waktu yang dibutuhkan untuk mengubahnya. Waktu yang cukup banyak dihabiskan pada awal-awal pengembangan hanya untuk membuat struktur warehouse yang benar. Desain warehouse yang baik dapat beradaptasi dengan perubahan tetapi karena kompleksitas proses memuat data dan hal yang harus dilakukan untuk membuat analisis serta pelaporan lebih mudah, perubahan-perubahan ini akan menghabiskan sumber daya yang dimiliki developer dan juga menyita cukup banyak waktu.

Banyak pertanyaan mengenai bisnis tidak dapat menunggu tim data warehouse untuk menyesuaikan sistem mereka untuk menjawabnya. Meningkatnya kebutuhan untuk jawaban yang lebih cepat adalah sebab mengapa konsep business intelligence self-service muncul.

Di sisi lain, dalam data lake, dikarenakan semua data disimpan dalam bentuk mentah dan selalu dapat diakses untuk seseorang yang memerlukannya, para pengguna diberdayakan untuk mengeksplor data melewati struktur dari warehouse untuk menjawab pertanyaan-pertanyaan yang ada.

Jika hasil dari eksplorasi terbukti bermanfaat dan memunculkan niat untuk mengulanginya, maka skema yang lebih formal dapat diaplikasikan dan otomatisasi serta usabilitas dapat dikembangkan untuk membantu emperluas hasil ke khalayak yang lebih luas. Hasil yang terbukti tidak berguna pun dapat dibuang tanpa mengubah struktur data yang telah dibuat dan tidak mengonsumsi sumber daya pengembangan yang ada.

- Data Lake Menyediakan Wawasan yang Lebih Cepat

Perbedaan terakhir merupakan hasil dari keempat lainnya. Karena data lake mengandung seluruh jenis data, karena data lake memungkinkan pengguna mengakses data tanpa diubah, di-cleansing dan distrukturisasi, data lake memungkinkan pengguna untuk mendapatkan hasil analisa lebih cepat daripada pendekekatan data warehouse tradisional.

Walaupun demikian, akses awal pada data yang dilakukan ini memiliki harganya tersendiri. Pekerjaan yang biasanya dilakukan tim pengembangan data warehouse mungkin tidak dilakukan untuk semua sumber data yang diperlukan untuk melakukan analisis. Hal ini menyebabkan pengguna memiliki kendali penuh untuk mengeksplor dan menggunakan data sebagaimana yang mereka inginkan tetapi tidak dengan para petinggi perusahaan yang tetap hanya menginginkan laporan dan KPI.

Dalam data lake, konsumen laporan operasional ini akan memanfaatkan pandangan data yang lebih terstruktur dalam data lake yang mencerminkan apa yang mereka selalu miliki sebelumnya di dalam data warehouse.

Pendekatan?

Merupakan sebuah dilema untuk memilih satu di antara dua teknologi ini. Jika perusahaan telah memiliki data warehouse yang mapan, tidak disarankan untuk membuang semua yang telah dikerjakan dan membangun lagi sedari awal. Meskipun demikian, seperti data warehouse lainnya, kemungkinan terjadinya masalah seperti yang telah dijabarkan di atas tetap ada. Maka dari itu, lebih baik bagi perusahaan untuk mengimplementasikan data lake bersama dengan data warehouse yang sudah ada. Data warehouse dapat terus beroperasi sebagaimana sebelumnya dan secara bersamaan, perusahaan juga mulai mengisi data lake-nya dengan sumber data yang baru. Data lake juga dapat digunakan untuk repositori arsip untuk data dari warehouse yang disediakan untuk para karyawan agar mereka dapat mengakses lebih banyak data dibanding sebelumnya. Seiring bertambah lamanya data warehouse di suatu perusahaan, perlu kiranya dipertimbangkan opsi untuk memindahkannya ke data lake atau mungkin kombinasi antara keduanya.

Teknologi?

Istilah data lake dapat dibilang telah menjadi persamaan dari teknologi big data. Salah satu teknologi big data yang mengadopsi sistem dari data lake adalah Paques. Paques Smart Data Lake yang merupakan salah satu pelopor big data di Indonesia telah mengaplikasikan penggunaan data lake ke dalam salah satu fitur unggulannya. Dengan adanya fitur ini, Paques dapat mengolah semua jenis data tanpa harus diubah terlebih dahulu sehingga menghemat waktu serta meningkatkan efisiensi.

Teknologi akan terus berkembang, pun begitu dengan teknologi mengenai data. Di manapun, perusahaan akan selalu memiliki pilihan untuk menjadi pioneer penggunaan teknologi, mengikuti tren teknologi, atau tertinggal oleh para pesaing dan pasar yang semakin dinamis, termasuk di Indonesia. Maka dari itu, untuk pemrosesan data yang lebih maksimal dan tetap efisien, mungkin Paques dapat menjadi solusinya.

Posting Komentar